这篇论文题为《AI as Normal Technology》(AI只不过是普通的技术),由Arvind Narayanan和Sayash Kapoor共同撰写,探讨了人工智能作为一种普通技术的发展轨迹及其对社会的潜在影响。

作者的核心观点是:AI并非一种革命性或颠覆性的力量,而是一种需要从历史视角理解的“普通技术”。这种视角有助于更准确地评估AI的风险和机遇,并制定合理的政策以应对其发展。

完整版论文:https://knightcolumbia.org/content/ai-as-normal-technology

以下为该论文摘要

超算百科编译

1. 核心论点:AI 是“正常技术”

作者认为,AI 并非一种特殊的技术,而是与历史上其他技术(如电力、计算机、互联网等)类似的工具。这些技术在最初都引发了过度乐观或悲观的预测,但最终它们的影响是渐进且复杂的。

将 AI 视为“正常技术”意味着不应将其视为一种独立的力量,而是嵌入在社会结构和技术生态系统中的工具。AI 的实际应用取决于技术方法的成熟度、应用场景的具体需求以及社会接受度。

2. 世界观视角:AI是一种认知框架

本文提出了一种看待AI的世界观,而非仅仅分析其技术特性。这种“普通技术”的视角强调:

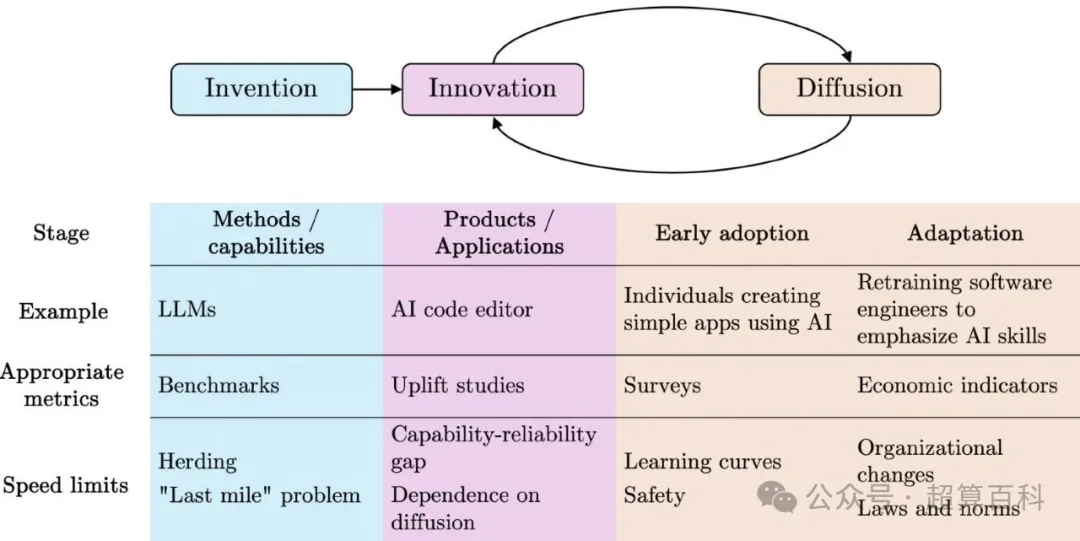

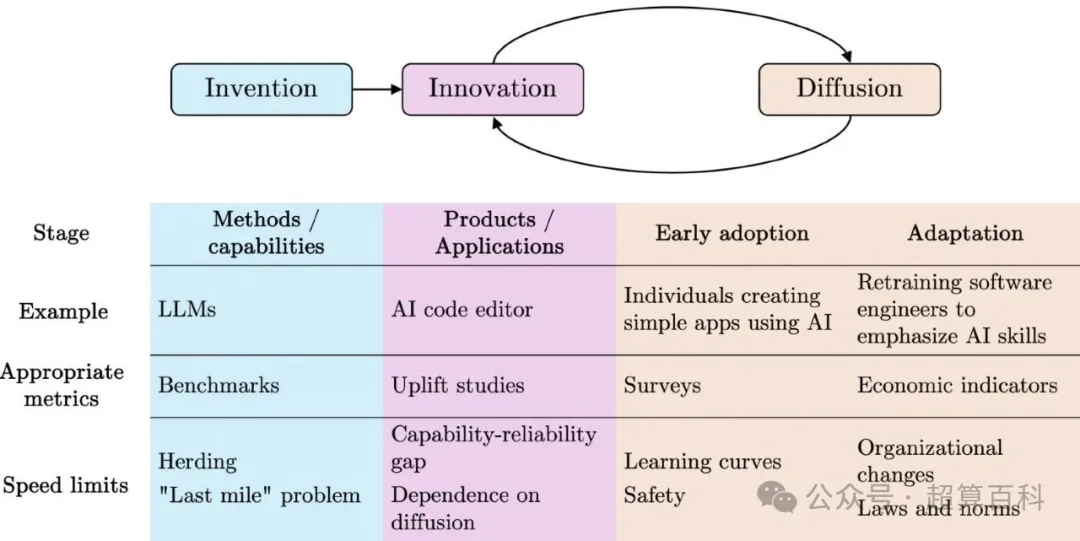

3. 技术发展的三阶段模型

作者提出了AI发展的三个关键阶段,AI对社会的影响将是长期、渐进的过程,而非一夜之间颠覆:

作者指出,当前关于AI的讨论往往过度聚焦于极端风险,尤其是围绕“超级智能”(AGI)可能失控的末日场景。然而,这些设想大多是基于推测而非实证分析,且AGI的实现时间表高度不确定。当前AI系统的能力仍然局限于特定任务,远未具备通用智能的特征。

将注意力过多地放在“超级智能”等遥远风险上,可能导致资源错配,忽视那些更具现实意义的风险。因此,作者主张应优先关注以下三类现实世界中的 AI 风险:

5. 治理与监管建议:反对封闭控制,提倡开放韧性

作者提出了一系列治理策略,旨在促进AI的负责任发展:

6. 对AI社会影响的长期展望

作者认为,人工智能对社会的影响将是渐进而非突变的。AI不会立即大规模取代人类工作,而是通过辅助和增强人类能力的方式,逐步改变劳动市场和职业结构。在许多专业领域,例如法律、医学和软件工程,AI的作用更多体现在“增强”而非“替代”,即帮助从业者提高效率、减少重复性工作,而非完全取而代之。

同时,AI的广泛应用也可能加剧一系列现有的社会问题,如隐私侵犯、信息操控、偏见固化和权力集中等。但另一方面,它也为公共服务优化、科学研究推进和社会治理创新提供了新的可能性。

历史经验表明,重大技术变革的真正潜力往往需要数十年时间才能充分显现。因此,对于AI的发展及其社会影响,应当采取耐心、务实和基于证据的态度来评估和应对。

7. 对AI研究生态的批判

人工智能领域的研究产出呈指数增长,arXiv上 AI/ML 论文数量的增长速度甚至不到两年就翻一番。然而,这种数量上的爆发并未带来相应比例的思想突破。AI领域历史上一直存在“从众效应”,即研究者倾向于围绕流行范式展开工作,而忽视了对非主流方向的探索。一个典型的例子是神经网络研究曾被边缘化数十年。

当前,Transformer架构已主导自然语言处理领域超过十年,尽管其局限性已被广泛认知,但仍未出现具有同等影响力的替代方案。研究表明,在论文数量激增的背景下,新思想更难脱颖而出,导致“范式固化”。这种趋势不利于长期创新,也削弱了AI社区应对未来挑战的能力。

8.实用导向的安全研究

当前许多AI安全研究的目标模糊且不切实际,例如试图确保未来“超级智能”与人类价值观“对齐”。这一目标既不现实,也不具备操作性。

作者主张,应将安全研究的重点转向更具实用价值的方向,包括:

9.长期展望:历史经验的启示

技术变革的历史表明,重大技术进步往往带来双刃剑效应。以工业革命为例,它极大地提升了生产效率,但也加剧了社会不平等、劳动剥削和城市贫困。

AI很可能也会产生类似的社会影响。一方面,它可以提升公共服务效率、推动科学研究;另一方面,也可能加剧隐私侵犯、信息操控、结构性歧视等问题。因此,我们应当从历史中吸取教训,提前设计制度性缓冲机制,以应对 AI 可能带来的负面后果。

10. 结论:回归理性与务实

本文呼吁社会各界对AI的讨论回归理性,避免被夸张叙事误导。政策制定者应关注现实可行的风险管理措施,而不是陷入对“末日场景”的幻想。

作者的核心观点是:AI并非一种革命性或颠覆性的力量,而是一种需要从历史视角理解的“普通技术”。这种视角有助于更准确地评估AI的风险和机遇,并制定合理的政策以应对其发展。

完整版论文:https://knightcolumbia.org/content/ai-as-normal-technology

以下为该论文摘要

超算百科编译

1. 核心论点:AI 是“正常技术”

作者认为,AI 并非一种特殊的技术,而是与历史上其他技术(如电力、计算机、互联网等)类似的工具。这些技术在最初都引发了过度乐观或悲观的预测,但最终它们的影响是渐进且复杂的。

将 AI 视为“正常技术”意味着不应将其视为一种独立的力量,而是嵌入在社会结构和技术生态系统中的工具。AI 的实际应用取决于技术方法的成熟度、应用场景的具体需求以及社会接受度。

2. 世界观视角:AI是一种认知框架

本文提出了一种看待AI的世界观,而非仅仅分析其技术特性。这种“普通技术”的视角强调:

- 区分AI发展的不同阶段(方法、应用、采纳)

- 拒绝“超级智能即将失控”的末日想象

- 关注现实世界中AI带来的具体问题与挑战

3. 技术发展的三阶段模型

作者提出了AI发展的三个关键阶段,AI对社会的影响将是长期、渐进的过程,而非一夜之间颠覆:

- AI 方法(AI Methods):指基础算法和模型的研发,例如深度学习、生成式 AI 等。这些方法的进步速度较快。

- AI 应用(AI Applications):将AI方法应用于特定领域(如医疗诊断、法律研究、自动驾驶)。这一过程通常需要数年甚至数十年的时间。

- AI 采用(AI Adoption):指社会对AI技术的实际采纳程度,包括制度、法规、用户习惯等因素。这是最慢的一个阶段,往往受到社会信任、伦理争议和监管框架的制约。

4. AI 风险的再评估与对“超级智能”叙事的批判

作者指出,当前关于AI的讨论往往过度聚焦于极端风险,尤其是围绕“超级智能”(AGI)可能失控的末日场景。然而,这些设想大多是基于推测而非实证分析,且AGI的实现时间表高度不确定。当前AI系统的能力仍然局限于特定任务,远未具备通用智能的特征。

将注意力过多地放在“超级智能”等遥远风险上,可能导致资源错配,忽视那些更具现实意义的风险。因此,作者主张应优先关注以下三类现实世界中的 AI 风险:

- 滥用风险:AI可能被用于恶意目的,例如虚假信息传播、自动化武器系统、深度伪造等。

- 结构性风险:AI在社会中放大现有的不平等、偏见和权力失衡,如招聘歧视、信贷评分偏差、执法中的种族偏见等。

- 安全漏洞:AI系统可能因设计缺陷、数据偏差或训练不足而导致错误决策,例如自动驾驶事故、医疗误诊等。

5. 治理与监管建议:反对封闭控制,提倡开放韧性

作者提出了一系列治理策略,旨在促进AI的负责任发展:

- 价值多元主义:政策应尊重不同利益相关者的价值观,避免一刀切的限制。

- 稳健性原则:政策应具有适应性,在面对不确定性时仍能有效运行。

- 早期预警系统:建立机制以识别和应对新兴的 AI 风险。

- 增强防御能力:投资于网络安全、基础设施保护等措施,以抵御 AI 可能带来的威胁。

- 透明度与问责制:推动AI系统的可解释性和责任追究机制,确保公众能够监督AI的使用。

6. 对AI社会影响的长期展望

作者认为,人工智能对社会的影响将是渐进而非突变的。AI不会立即大规模取代人类工作,而是通过辅助和增强人类能力的方式,逐步改变劳动市场和职业结构。在许多专业领域,例如法律、医学和软件工程,AI的作用更多体现在“增强”而非“替代”,即帮助从业者提高效率、减少重复性工作,而非完全取而代之。

同时,AI的广泛应用也可能加剧一系列现有的社会问题,如隐私侵犯、信息操控、偏见固化和权力集中等。但另一方面,它也为公共服务优化、科学研究推进和社会治理创新提供了新的可能性。

历史经验表明,重大技术变革的真正潜力往往需要数十年时间才能充分显现。因此,对于AI的发展及其社会影响,应当采取耐心、务实和基于证据的态度来评估和应对。

7. 对AI研究生态的批判

人工智能领域的研究产出呈指数增长,arXiv上 AI/ML 论文数量的增长速度甚至不到两年就翻一番。然而,这种数量上的爆发并未带来相应比例的思想突破。AI领域历史上一直存在“从众效应”,即研究者倾向于围绕流行范式展开工作,而忽视了对非主流方向的探索。一个典型的例子是神经网络研究曾被边缘化数十年。

当前,Transformer架构已主导自然语言处理领域超过十年,尽管其局限性已被广泛认知,但仍未出现具有同等影响力的替代方案。研究表明,在论文数量激增的背景下,新思想更难脱颖而出,导致“范式固化”。这种趋势不利于长期创新,也削弱了AI社区应对未来挑战的能力。

8.实用导向的安全研究

当前许多AI安全研究的目标模糊且不切实际,例如试图确保未来“超级智能”与人类价值观“对齐”。这一目标既不现实,也不具备操作性。

作者主张,应将安全研究的重点转向更具实用价值的方向,包括:

- 提高模型的可解释性。

- 建立有效的数据偏见检测机制。

- 发展自动化工具以进行系统安全性测试与监控。

- 使用语言模型作为“自动法官”,评估AI行为的安全性。

- 设计层级控制系统,由简单可靠的AI监督复杂但可能不可靠的AI。

9.长期展望:历史经验的启示

技术变革的历史表明,重大技术进步往往带来双刃剑效应。以工业革命为例,它极大地提升了生产效率,但也加剧了社会不平等、劳动剥削和城市贫困。

AI很可能也会产生类似的社会影响。一方面,它可以提升公共服务效率、推动科学研究;另一方面,也可能加剧隐私侵犯、信息操控、结构性歧视等问题。因此,我们应当从历史中吸取教训,提前设计制度性缓冲机制,以应对 AI 可能带来的负面后果。

10. 结论:回归理性与务实

本文呼吁社会各界对AI的讨论回归理性,避免被夸张叙事误导。政策制定者应关注现实可行的风险管理措施,而不是陷入对“末日场景”的幻想。

AI的发展路径并非命中注定,而是由技术进步、社会选择和制度安排共同决定。面对不确定性,我们需要采取稳健、灵活、包容的治理策略,以引导AI 向有益于社会的方向发展。